ПОСЛЕДНИЕ НОВОСТИ

- 20:10 Нетаниягу сделал важное заявление на заседании правительства

- 20:00 Что нужно добавить к кофе, чтобы без усилий похудеть - эксперты раскрыли секрет

- 19:50 ЦАХАЛ обнародовал детали ареста террористов в школах Сектора Газа

- 19:37 Решил ли Израиль мстить Ирану – ответ МИД Великобритании

- 19:24 Коалиция Нетаниягу готовится к выходу Ганца из правительства - СМИ

- 19:13 Байден сделал важное заявление об Израиле и Иране

- 19:02 7 "вежливых" фраз, которые очень обижают людей, назвали психологи

- 18:50 Восстановление "пояса Газы" - правительство представило новый план

- 18:38 Иран может атаковать Израиль ядерными боеголовками – экс-советник Трампа

- 18:27 В Японии произошло мощное землетрясение магнитудой 6,4 – СМИ

- 18:11 Атака "Хизбаллы" на севере – появилась новая информация

- 18:02 Украина пересекла "ядерную" красную линию путина - СМИ

- 18:00 У трех знаков Зодиака наступает самый счастливый период года - астрологи

- 17:49 Атака Ирана - WSJ рассказал, каким будет ответ Израиля

- 17:40 В США объяснили, почему не защищают Украину от атак, как Израиль: Не собираемся

- 17:25 Министр транспорта Регев срочно обратилась к израильским авиакомпаниям

- 17:10 Главный раввин Ирана обратился к официальному Тегерану по поводу заложников ХАМАСа

- 17:00 Психолог рассказал, какие фразы нельзя говорить друзьям и почему

- 16:50 Персонал баз ЦАХАЛа рассказал, как отбивали атаку Ирана

- 16:37 Минздрав предупредил израильтян о трех опасных товарах на полках магазинов

- 16:25 Обстрел севера "Хизбаллой" - появились новые подробности

- 16:20 Смертоносный обстрел жилых домов в Чернигове – посольство Украины выступило с призывом

- 16:00 Три продукта, которые помогут похудеть женщинам после 45 лет

- 15:50 Нетаниягу рассказал, о чем говорил на встрече с главами МИД Британии и Германии

- 15:38 Захват корабля Ираном - компания MSC сообщила новые данные

Больше новостей

Новости Израиля

Нетаниягу сделал важное заявление на заседании правительства

20:10, Сегодня

По словам Нетаниягу, террористы ХАМАСа стремились к искоренению израильтян, но вместо этого "мы искореним их и укоренимся".

ЦАХАЛ обнародовал детали ареста террористов в школах Сектора Газа

19:50, Сегодня

Военные ЦАХАЛа перед началом операции оповестили гражданских о необходимости эвакуации из здания.

Решил ли Израиль мстить Ирану – ответ МИД Великобритании

19:37, Сегодня

Высокопоставленный британский чиновник заявил, что Лондон, среди всего прочего, ждет скоординированных санкций против Ирана.

Коалиция Нетаниягу готовится к выходу Ганца из правительства - СМИ

19:24, Сегодня

В коалиции уже нашли замену Бени Ганцу после отставки.

Мировые новости

Решил ли Израиль мстить Ирану – ответ МИД Великобритании

19:37, Сегодня

Высокопоставленный британский чиновник заявил, что Лондон, среди всего прочего, ждет скоординированных санкций против Ирана.

Байден сделал важное заявление об Израиле и Иране

19:13, Сегодня

Байден назвал сценарий, при котором США могут быть втянуты в противостояние между Израилем и Ираном.

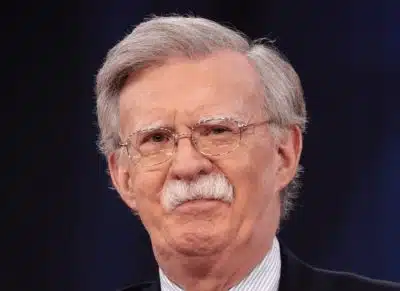

Иран может атаковать Израиль ядерными боеголовками – экс-советник Трампа

18:38, Сегодня

По его словам, Израиль рассматривается в Иране как "маленький сатана".

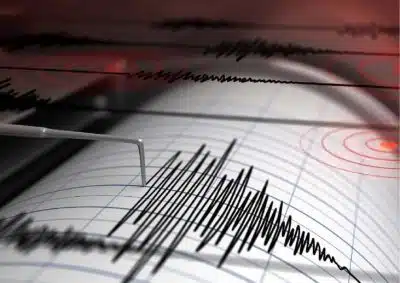

В Японии произошло мощное землетрясение магнитудой 6,4 – СМИ

18:27, Сегодня

СМИ пишут, что землетрясение в Японии может спровоцировать цунами.

Политика

Нетаниягу сделал важное заявление на заседании правительства

20:10, Сегодня

По словам Нетаниягу, террористы ХАМАСа стремились к искоренению израильтян, но вместо этого "мы искореним их и укоренимся".

Решил ли Израиль мстить Ирану – ответ МИД Великобритании

19:37, Сегодня

Высокопоставленный британский чиновник заявил, что Лондон, среди всего прочего, ждет скоординированных санкций против Ирана.

Коалиция Нетаниягу готовится к выходу Ганца из правительства - СМИ

19:24, Сегодня

В коалиции уже нашли замену Бени Ганцу после отставки.

Байден сделал важное заявление об Израиле и Иране

19:13, Сегодня

Байден назвал сценарий, при котором США могут быть втянуты в противостояние между Израилем и Ираном.

Экономика

МВФ обнародовал тревожный прогноз относительно экономики Израиля

21:38, Вчера

МВФ учел все текущие события, влияющие на экономику.

Анализ цен на продукты к Песаху — в каких магазинах покупать дешевле

11:38, Вчера

Израильтянам советуют делать покупки заранее, чтобы избежать роста цен по мере приближения к празднику.

Еще одна компания объявила о повышении цен на свои товары в Израиле

10:38, Вчера

Товары компании в магазинах подорожают на 20 процентов.

В Центрбюро статистики сообщили, какой была инфляция в марте

22:37, 15 апреля

В Центрбюро статистики опубликовали цифры, которые превысили прогнозы экономических аналитиков.

Новости партнеров

Впервые в Израильской Опере: «Диалоги кармелиток» Франсиса Пуленка

11:29, Сегодня

В Израильской Опере в Тель-Авиве «Диалоги кармелиток» будут показаны впервые с 28 мая по 3 июня. Постановщик - Оливье Пи. Дирижер – маэстро Ашер Фи...

Новые сериалы о разведчиках, шпионах и расследованиях

19:03, 15 апреля

Деятельность спецслужб и расследования запутанных и громких преступлений всегда привлекают и захватывают. Поэтому фильмы и сериалы на эти темы неиз...

Иногда они возвращаются

18:53, 15 апреля

Насколько велик риск повторного инфаркта или инсульта и что делать, чтобы этого не случилось?

Песах с комфортом и удовольствием

13:56, 11 апреля

На Песах у многих израильтян было принято отправляться за границу – даже несмотря на то, что цены на полеты в это время всегда взлетали.

Новости СНГ

Украина пересекла "ядерную" красную линию путина - СМИ

18:02, Сегодня

Украина нанесла удар по объекту, который был упомянут в указе путина.

В США объяснили, почему не защищают Украину от атак, как Израиль: Не собираемся

17:40, Сегодня

В США выделили четыре фактора, обуславливающие такую позицию в отношении Израиля и Украины.

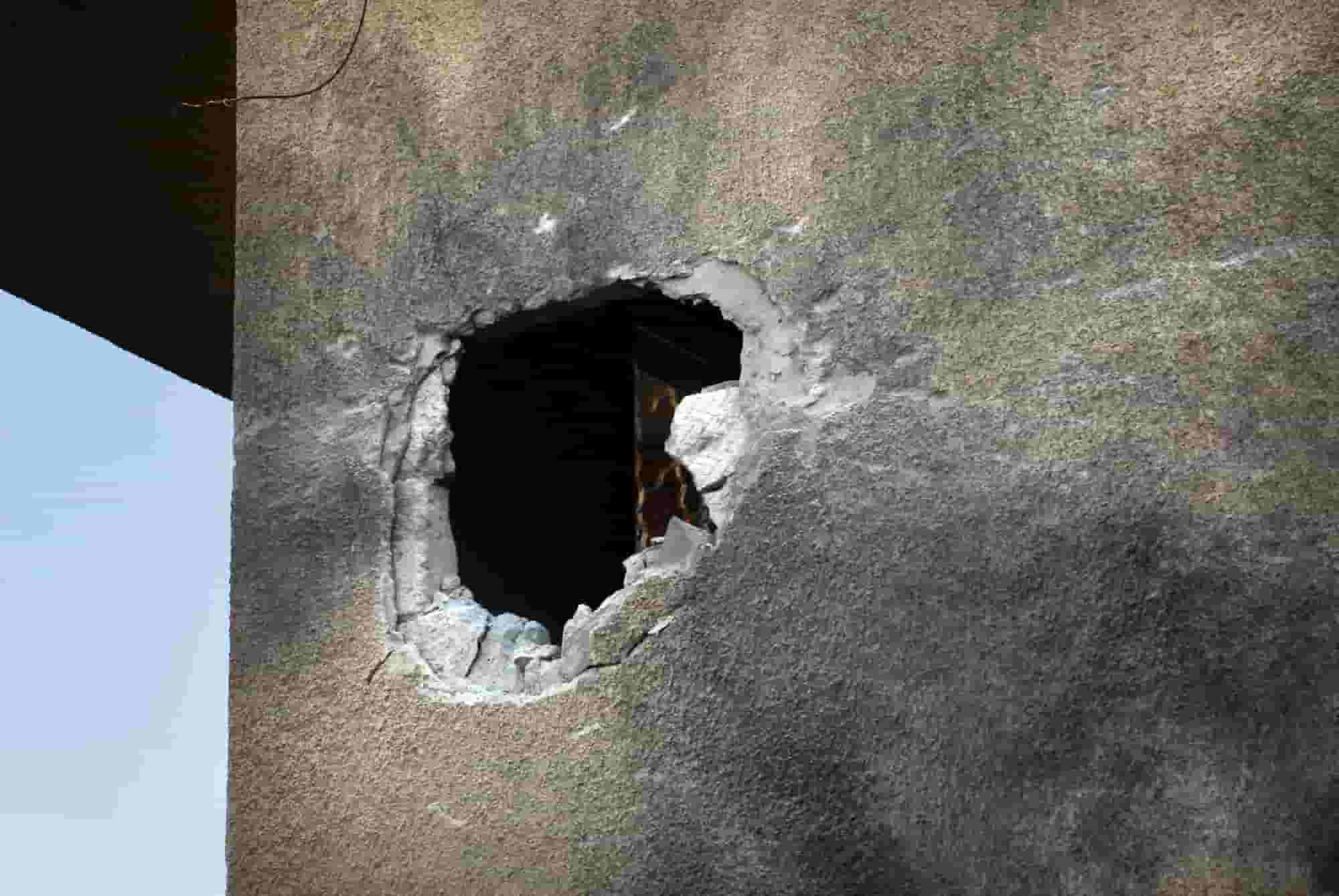

Смертоносный обстрел жилых домов в Чернигове – посольство Украины выступило с призывом

16:20, Сегодня

В заявлении посольства сказано: "Как долго мы будем продолжать хоронить наших детей, женщин и мужчин?".

Украина атаковала российский завод, где производят стратегические бомбардировщики

14:50, Сегодня

Украина нанесла удар по военному объекту, где производятся и ремонтируются стратегические бомбардировщики Ту-22М и Ту-160МЮ способные нести ядерное...